Análise de Desempenho de Modelos de Linguagem

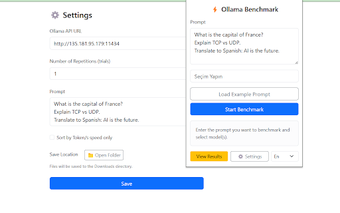

O Ollama Benchmark é uma extensão do Chrome que permite avaliar e comparar o desempenho de Modelos de Linguagem (LLMs) como Mistral, LLaMA e Qwen. Com recursos que possibilitam executar testes de benchmark baseados em prompts, os usuários podem analisar métricas essenciais como contagem de tokens, tempo de resposta e velocidade. A interface multilíngue, disponível em inglês e turco, torna a ferramenta acessível a uma ampla gama de usuários.

Entre os principais recursos, destaca-se a possibilidade de selecionar múltiplos modelos para comparação, além da opção de exportar resultados em formatos como .txt, .csv e .json. O armazenamento local de configurações e resultados garante que o usuário possa manter um histórico de suas análises. Totalmente gratuito e sem coleta de dados, o Ollama Benchmark é uma ferramenta valiosa para otimizar fluxos de trabalho de IA.